【重要・免責事項】

この記事に記載している4級基準点測量の作業方法は、私(Tanaka Ryoji)がこれまでの現場経験、各種公開資料、国土地理院の「公共測量作業規程の準則」(最新版:令和7年改正版など)および関連する運用基準・技術資料などをもとに、個人的に整理・理解した内容に過ぎません。

あくまで個人の私見・勉強メモであり、国土地理院や国土交通省が公式に発行・保証するものではありません。記載内容が公式規程と異なる可能性、または最新の改正点が反映されていない可能性があります。

実際の測量業務・申請・検定などでご利用になる場合は、必ず以下の最新の正規資料を最優先でご確認ください。

- 国土地理院「作業規程の準則」(全文PDFなど):https://www.gsi.go.jp/gijyutukanri/gijyutukanri41018.html

- 関連する運用基準、発注機関の特記仕様書、監督員の指示

- 必要に応じて管轄の地方測量部・支所への照会

当記事の内容を参考にした結果生じたいかなる不利益・トラブル・損害等についても、一切の責任を負いかねます。ご理解の上、自己責任でご覧ください。

F9P 「非検定機」× ソフトバンクRTCM × VRS × 公共測量4級(2点)という前提での作業方法や注意点についてまとめました。

前提条件の整理

受信機:u-blox F9P(非検定)

補正情報:ソフトバンク VRS(G-VRS)

電子基準点距離:約15 km

等級:公共測量 4級基準点

点数:2点

観測の独立性と記録の丁寧さ が重要になります。

■結論

・ソフトバンクG-VRSだけ使ってOK

・ 電子基準点は「参照用」に使えばよい

・ F9Pでも 2セッション+ログ保存+較差確認 をすれば実務上問題なし

*** 推奨・安全側の作業手順(実務版)***

事前確認(必須)

近傍既知点でチェック(1分でOK)

↓

ソフトバンクG-VRSに接続

↓

FIX確認

↓

既知座標との差確認

目安 平面 ±2cm以内、標高 ±3cm以内

■ここでズレる場合:

アンテナ高

ジオイド(JGD2024)

投影法

RTCMマウントポイント

を必ず疑う。

本観測:1セッション目

【点1】

ソフトバンクG-VRS接続

↓

FIX後、5〜7分観測

↓

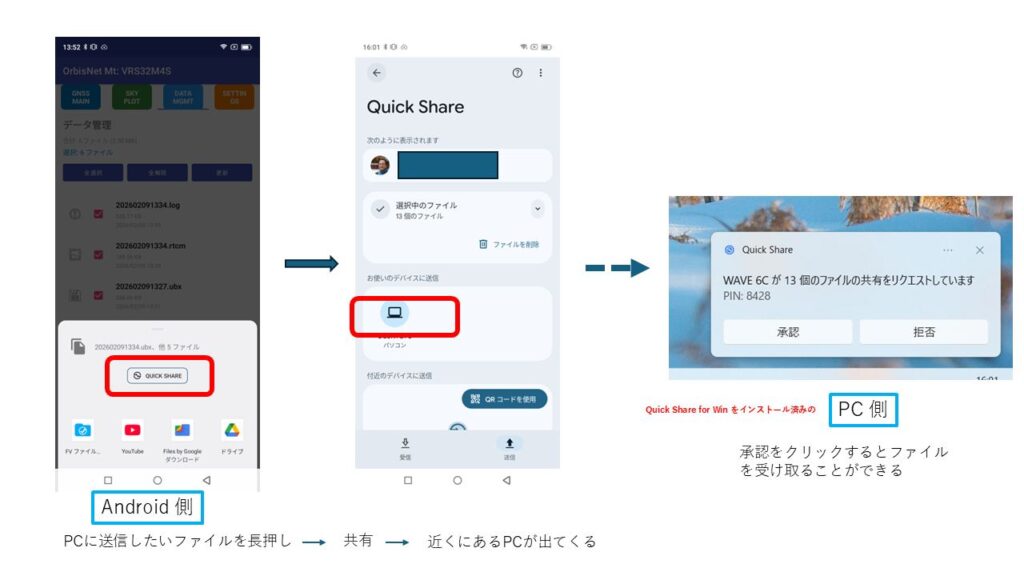

UBXログ保存

↓

アンテナ高記録

↓

点2へ移動

↓

FIX維持(通信を切らない)

↓

同一セッション扱い

【点2】

5〜7分観測

↓

UBXログ保存

↓

アンテナ高記録

↓

これで1セッション

本観測:2セッション目(最重要)

必ず「独立」させる

↓

NTRIP切断

↓

電源OFF or 再起動

↓

再接続してFIX再取得

↓

最低30分、できれば1時間以上空ける

↓

点2 → 点1(順番逆)

↓

点2:5〜7分観測

↓

点1:5〜7分観測

これで2セッション完了

************************************************

■非検定機(F9P)対策

同一FIXの連続使用は避ける

再初期化を明確に行う

時間差を確保

検定機でなくても、測量行為の信頼性を担保できるように

■ソフトバンクG-VRSは

複数電子基準点を内部使用

仮想基準点は観測点近傍

15kmという距離は 後処理ならOKだがRTKならVRSの方が有利

現場RTKでは ソフトバンク > 単一電子基準点

■推奨計算処理フロー

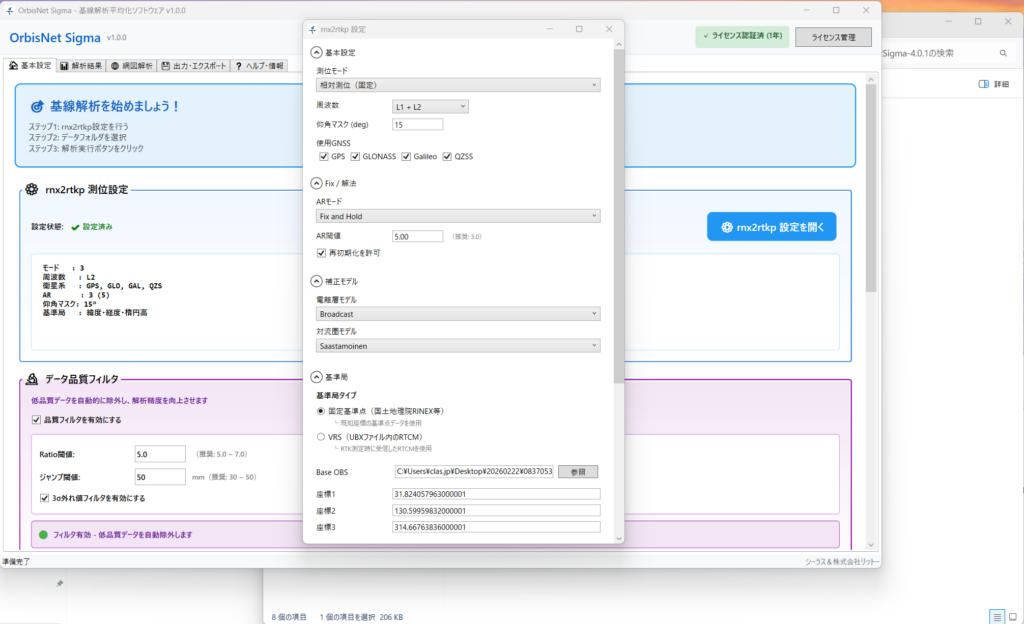

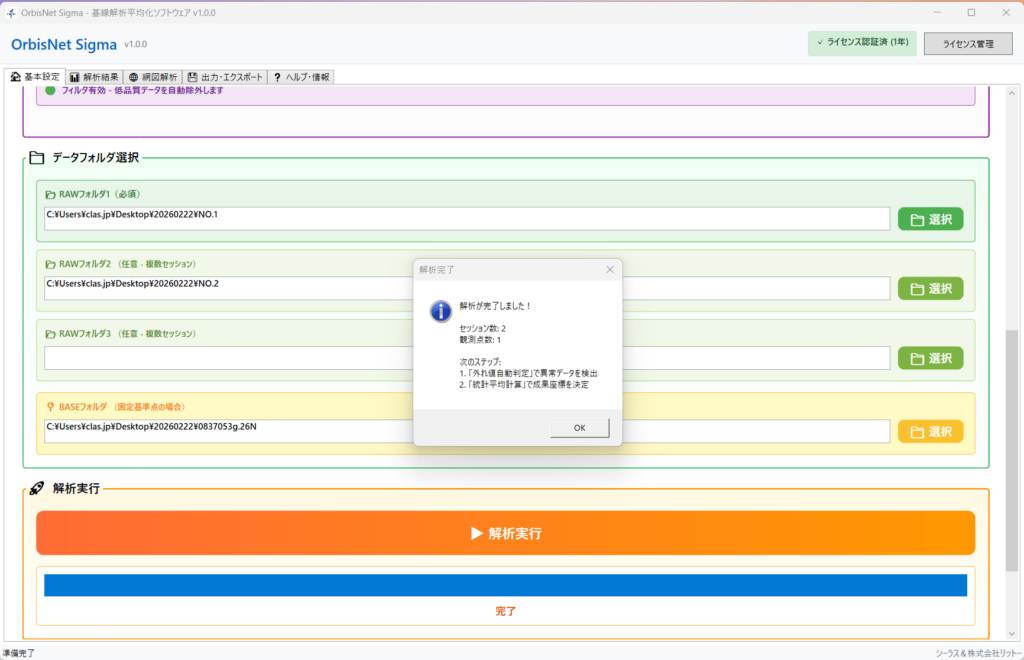

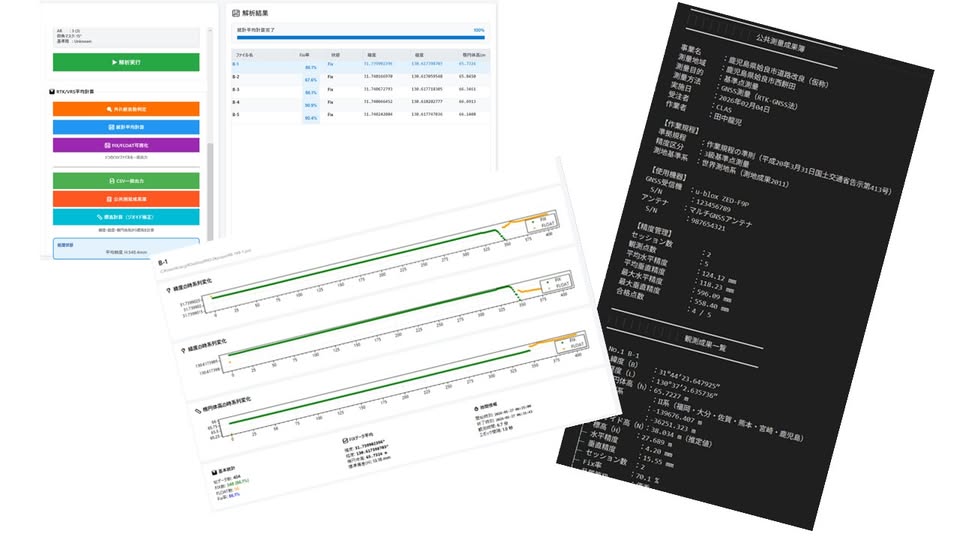

OrbisNet Sigma を使って、

UBX保存、RTCM保存(OrbisNetロガーのデータをダウンロード)

↓

convbin → RINEX化

↓

rnx2rtkp(baseline / kinematic)

↓

セッション間較差確認

↓

平均化

較差目安

平面 ≤ 2 cm

標高 ≤ 3 cm

超えたら再観測。

電子基準点は「保険」として使う(ソフトバンクG-VRSが主)

電子基準点(15km)は

後処理で比較

報告書の説明用

という位置づけがベスト。

■実務でよくあるNG例(注意)

❌ 2セッションとも同じFIX状態

❌ 再初期化せず連続観測

❌ ログ未保存

❌ セッション差を見ていない

■提出時・説明(実務用)

本測量はGNSS測量(VRS方式)により実施し、

各点について独立した2セッション観測を行い、

セッション間較差の確認後、平均化処理を行った。

■まとめ(最適解)

ソフトバンクG-VRSでOK

2セッション必須

再初期化・時間差必須

UBX保存+後処理で品質担保

以上